这次要做的事情是这样, 分别在服务器上和本地的pycharm上运行pyspark程序, 程序很简单,就是wordcount, 代码如下: from pyspark import SparkContext sc = SparkContext('local[2]', 'wordcount') rdd = sc....

”pyspark“ 的搜索结果

1、列重命名: train_data = train_data.toDF('imei', 'pkgName', 'timestamp') 2、删除某一列: 3、选取某些列: train_data = train_data.filter(train_data.date != "2021-03-01")

包含了Learning PySpark英文版清晰PDF,官方下载的代码,以及spark和Anaconda的安装教程。

Pyspark综合案例(pyspark安装和java运行环境配置)

问题遇到的现象和发生背景 在pyspark环境下,无法使用sortbykey函数 用代码块功能插入代码,请勿粘贴截图 rdd = sc.parallelize([("hello",1),("world",2),("china",3),("Beijing",4)]) print("rdd数据集做sorybyKey...

这段时间PySpark数据分析基础系列文章将持续讲述Pyspark.MLlib这一大块核心内容,更贴近我们的大数据分布式计算结合数据分析。上篇内容我们讲述了一些属于机器学习最基础的内容和相关原理,内容也由浅入深。接下来...

用于大数据分析的PySpark备忘单 对于本文,我们使用了上公开可用的笔画预测数据集。 本教程包含以下主题: 加载数据中 查看资料 选择数据 计数数据 独特价值 筛选资料 订货数据 创建新变量 删除资料 更改数据类型 ...

注意:在前提安装配置好(有机会可以安排一下教程)

主要原因是pyspark直接读取excel的话,设计到版本的冲突问题。commons-collections-3.2.2.jar 我的CDH中这个的版本是3.2.2.但是pyspark读取excel要求要collections4以上的版本,然后我下载放进去也没作用,因为时间...

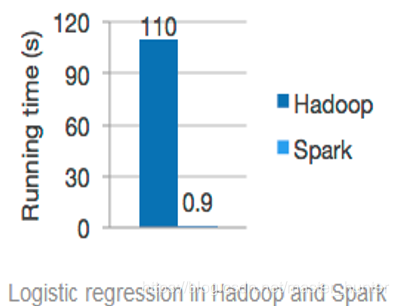

Apache Spark是处理和处理大数据时使用最广泛的框架之一,Python是用于数据分析、机器学习等的最广泛的编程语言之一。所以,为什么不一起使用呢?...这就是Spark with Python(也被称为PySpark)出...

pyspark+问题总结

标签: 范文/模板/素材

pyspark+问题总结

1. 常用package和参数 import pandas as pd import numpy as np import matplotlib.pyplot as plt from sklearn.mixture import GaussianMixture as GMM from sklearn.mixture import GaussianMixture ...

pyspark示例。

<p><img alt="" height="639" src=...但是在运行pyspark就包这样的错,是因为没激活anaconda吗,我没听说过还需要激活这玩意儿,求助!!!</p>

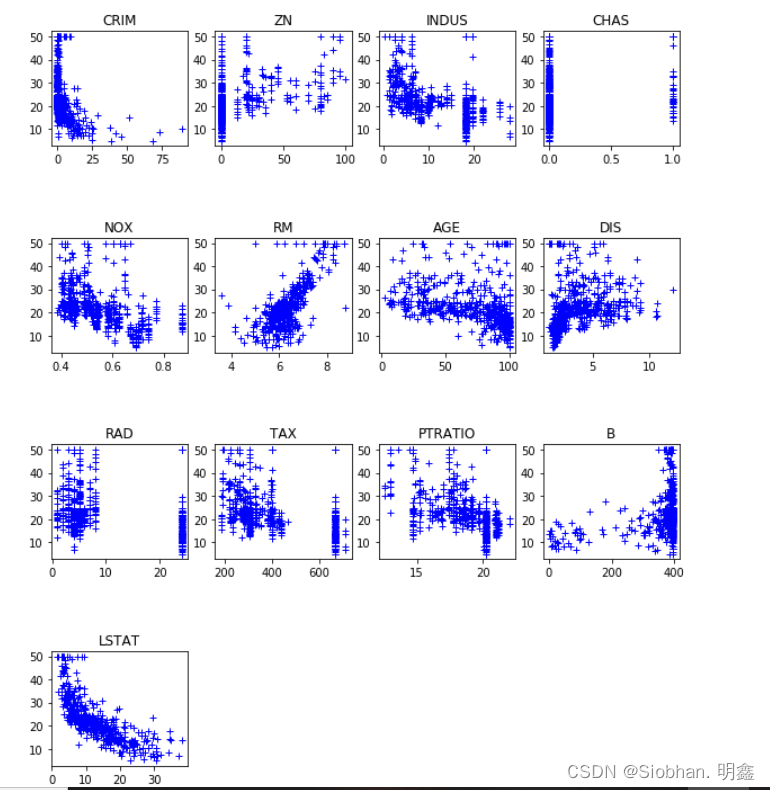

利用pyspark实现随机森林分析

mapPartitions 对一个分区进行操作,如果要实现向map一样的处理,函数里面需要遍历分区中的每一行。 def f(partitionData): for element in partitionData: pass # return updated data df.rdd.mapPartitions(f...

PySpark RDD cheat Sheet python

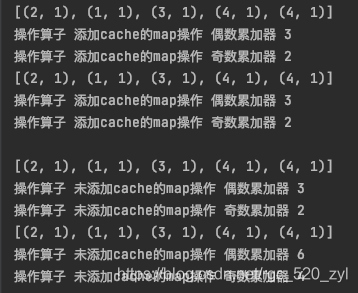

PySpark常用数据计算算子

Pyspark交互式编程 有该数据集Data01.txt 该数据集包含了某大学计算机系的成绩,数据格式如下所示: Tom,DataBase,80 Tom,Algorithm,50 Jim,DataBase,90 Jim,Algorithm,60...... 根据给定的数据集,在pyspark中...

新增hadoop-3.3.1\namenode、hadoop-3.3.1\datanode、hadoop-3.3.1\checkpoint、hadoop-3.3.1\checkpoint-edits目录。...windows解压tar.gz失败,我们可以上传到linux上,解压再打包成zip格式,再到windows上解压zip...

我的是spark-3.3.3版本,日志文件名字为log4j2....进入python安装目录下的lib/site-packages目录下,使用pip下载安装pyspark,这里使用国内清华大学镜像网站。安装pyspark库成功后,重新运行代码,然后还是报错。

pyspark submit 使用自定义虚拟环境

简介DataFrame结构代表的是数据的一个不可变分布式集合,其数据都被组织到有名字的列中,就...本文将着重介绍PySpark中DataFrame的各种创建方式,以及与RDD、Pandas之间的转换。DataFrame的创建1. 从RDD中创建为了从...

推荐文章

- Java---简单易懂的KNN算法_jf.knn-%; 9 &-程序员宅基地

- 最新版ffmpeg 提取视频关键帧_从视频中获取flag-程序员宅基地

- 【ARM Cache 系列文章 11 -- ARM Cache 直接映射 详细介绍】

- Objective-C学习计划

- 【数据结构】最小生成树(Prim算法、Kruskal算法)解析+完整代码

- python访问组策略_python 模块 wmi 远程连接 windows 获取配置信息-程序员宅基地

- html把div做成透明背景,DIV半透明层 CSS来实现网页背景半透明-程序员宅基地

- 关机恶搞小程序

- mnist手写数字分类的python实现_TensorFlow的MNIST手写数字分类问题 基础篇-程序员宅基地

- wxpython窗口跳转_WxPython-用按钮打开一个新窗口-程序员宅基地