”spark安装“ 的搜索结果

Apache Spark 是一个快速的通用集群计算系统。它提供了Java, Scala, Python ,R 四种编程语言的 API 编程接口和基于 DAG 图执行的优化引擎。它还支持一系列丰富的高级工具:处理结构化数据的 Spark SQL,用于机器...

Spark开发环境搭建.pdf

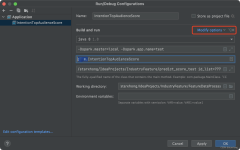

安装Spark之前,需要安装JDK、Hadoop、Scala。显示上面的正常运行界面,表示本地的spark环境已搭建完成!环境变量Path添加条目%SCALA_HOME%\bin。为了验证Scala是否安装成功,开启一个新的cmd窗口。环境变量Path添加...

为了避免MapReduce框架中多次读写磁盘带来的消耗,以及更充分地利用内存,加州大学伯克利分校的AMP Lab提出了一种新的、开源的、类Hadoop MapReduce的内存编程模型Spark。一、spark是什么?Spark是一个基于内存的...

Apache Spark是一个基于内存的分布式计算框架,它提供了高效、强大的数据处理和分析能力。与传统的Hadoop MapReduce相比,Spark的主要优势在于其能够将数据集缓存在内存中,从而大大减少了磁盘I/O操作,提高了数据...

spark安装1

标签: spark hadoop

2、易用性Spark支持Java、Python和Scala的API,还支持超过80种高级算法,使用户可以快速构建不同的应用 3、通用性Spark提供了统一的解决

首先来聊聊什么是Spark?为什么现在那么多人都用Spark? Spark简介: Spark是一种通用的大数据计算框架,是基于**RDD(弹性分布式数据集)**的一种计算模型。那到底是什么呢?可能很多人还不是太理解,通俗讲就是可以...

Spark安装文档以及介绍

标签: spark

Spark的介绍,spark的安装配置,认识spark,spark的特点

适合大数据分析初学者,安装大数据分析工具spark,并用python语言测试(保姆级教学)。

JAVA+HADOOP+SPARK安装

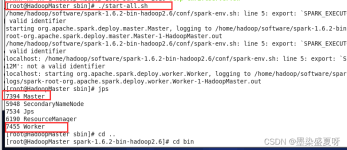

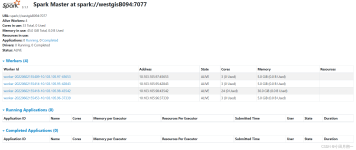

完整的spark安装指南,包含shell命令和步骤图片。

主要介绍了centOS7下Spark安装配置教程详解,非常不错,具有一定的参考借鉴价值,需要的朋友可以参考下

Spark学习笔记[3]-Spark安装部署 1、下载对应版本的spark 官网我始终都下不下来,推荐一个国内的镜像: https://mirrors.tuna.tsinghua.edu.cn/apache/spark 2、概述 2-1 安装模式 虽然Spark是一个分布式...

hive on spark spark 安装配置 安装对应版本scala spark和scala的版本需要匹配,不然安装后启动会报错 官网下载源码包 http://spark.apache.org/downloads.html 其他版本可以去...

启动 zookeeper。一键启动启动spark。二 . 解压 Spark 安装包并改名。2.slaves 配置。一 . 下载Spark。

spark安装与搭建包,文件夹有spark-3.0.3-bin-hadoop2.7 (支持hadoop3.2以下),spark搭建步骤和spark课件。

推荐文章

- Python字典类型及操作_字典是键值对的结合,键值对之间没有顺序。-程序员宅基地

- shader学习集锦-程序员宅基地

- python 一个整数,它加上100后是一个完全平方数,再加上168又是一个完全平方数,请问该数是多少?_一个整数,它加上100后是一个完全平方数,再加上168又是一个完全平方数,请问该数是-程序员宅基地

- Linux时间子系统之六:高精度定时器(HRTIMER)的原理和实现 ._timekeeping_delta_to_ns-程序员宅基地

- TTS | 语音合成模型实验结果经验总结_use_duration_discriminator-程序员宅基地

- Android技术框架篇(三):MVVM框架_android mvvm-程序员宅基地

- 第4章c语言作业_c语言第四章作业-程序员宅基地

- PCL1.8+Ubuntu16.04安装详解-程序员宅基地

- win11 文件拖到任务栏无法打开的解决办法_win11文件拖到任务栏打不开-程序员宅基地

- STM32WB55大半年开发记录,血氧心率检测手环-程序员宅基地