”梯度下降参数不收敛“ 的搜索结果

可以优化大量的机器学习模型,如线性回归、逻辑回归、神经网络等。梯度下降算法是一种通用的优化算法,适用于不同的损失函数。...梯度下降算法对于超参数的选择较为敏感,需要手动调整学习率、动量等参数。

有监督学习和无监督学习 机器学习,分为有监督学习和无监督学习。 有监督学习,就是有训练集,有label,我们是可以知道模型输出是什么样子的。而无监督学习,没有训练集,没有label,提前无法知道输出的样子。...

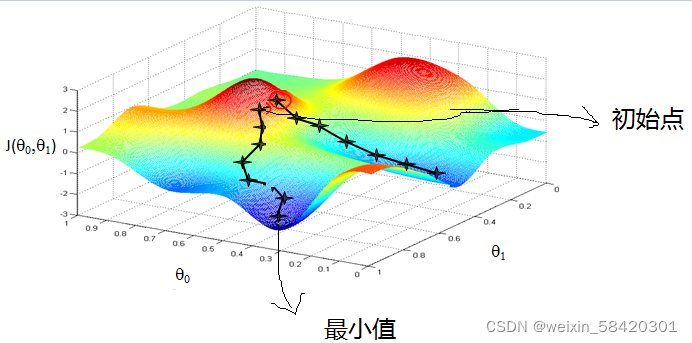

在梯度下降法中,参数(或变量)沿着负梯度的方向进行更新,以降低函数值。选择初始点: 选择一个初始点作为优化的起始点。计算梯度: 在当前点计算函数的梯度(导数)。梯度是一个向量,包含每个变量的偏导数。更新...

梯度下降(批量梯度下降)

标签: 梯度下降

本文主要介绍随机梯度下降法

三种梯度下降方法的区别和优缺点

本文介绍梯度下降法的概念和主要内容

在求解机器学习算法的模型参数,即无约束优化问题时,梯度下降(Gradient Descent)是最常采用的方法之一,另一种常用的方法是最小二乘法。这里就对梯度下降法做一个完整的总结。 1. 梯度 在微积分里面,对多元...

假设我们位于黄山的某个山腰处,山势连绵不绝,不知道怎么下山。于是决定走一步算一步,也就是每次沿着当前位置最陡峭最易下山的方向前进一小步,然后继续沿下一个位置最陡方向前进一小步。这样一步一步走下去,...

逻辑回归的参数计算:牛顿法,梯度下降(上升)法,随机梯度下降法,批量梯度下降法 前面文章中对逻辑回归进行了讲解,下面来说一说逻辑回归的参数是怎么计算的。 逻辑回归的计算使用的是最大似然方法。记zi=w⋅xiz^...

梯度下降(Gradient Descent)是一种常用的优化算法,常用于机器学习中的参数优化。 梯度下降的基本思想是,沿着函数的梯度(或者说导数)的反方向,以步长为步进量逐渐逼近函数的最小值点。在机器学习中,梯度下降...

梯度方向是,步长设为常数Δ,这时就会发现,如果用在梯度较大的时候,离最优解比较远,W的更新比较快;在这儿,我们再作个形象的类比,如果把这个走法类比为力,那么完整的三要素就是步长(走多少)、方向、出发点...

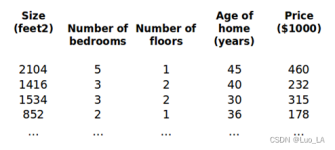

一、梯度下降+随机梯度下降+小批量梯度下降 假设m个样本作为输入: 需要拟合的函数为: 目标是为了找到最合适的参数,使得拟合的效果最好,因此可以定义如下损失函数: 如何求解呢,这里我们就需要用到梯度...

1. 梯度下降法的作用 梯度下降法用来求函数的极小值,且是一种迭代算法,由于计算机效率高,在机器学习中经常使用。梯度下降法常求凸函数(如机器学习中各种代价函数)的极小值,因为凸函数只有一个极小值,使用梯度...

梯度下降方法(三种不同地梯度下降方法简介)标签:#优化##机器学习##梯度下降##深度学习#时间:2018/10/17 14:20:47作者:小木梯度下降是一种迭代优化的方法,它的目标是求解一个函数的最小值。我们以一个简单的例子...

我们每个人都会在我们的生活或者工作中遇到各种各样的最优化问题,比如每个企业和个人都要考虑的一个问题“在一定成本下,如何使利润最大化”等。最优化方法是一种数学方法,它是研究在给定约束之下如何寻求某些...

本文主要介绍随机梯度下降法

文 | Summer Clover@知乎本文已获作者授权,禁止二次转载这是Deep Learning Theory里很基本也很核心的一个问题。在这个问题上,初学者容易被入门教学误导,非此...

(梯度下降法作为机器学习中较常使用的优化算法,其有着三种不同的形式:批量梯度下降(Batch Gradient Descent)、随机梯度下降(Stochastic Gradient Descent)以及小批量梯度下降(Mini-Batch Gradient Descent)...

使用迭代优化方法:梯度下降(GD),在训练集上,它可以逐渐调整模型参数以获得最小的损失函数,最终,参数会收敛到和第一种方法相同的的值。梯度下降的变体形式:批量梯度下降(Batch GD)、小批量梯度下降(Mini-batch GD...

推荐文章

- 数据预测模型_预测疫情走势,联通大数据疫情传播趋势仿真模型助力复工复产...-程序员宅基地

- APUE学习笔记:常用标准IO函数_在使用fopen函数读到文件末尾返回值是eof-程序员宅基地

- lol祖安服务器维护,LOL小学生最聚集10大服务器:艾欧尼亚倒数第一-程序员宅基地

- java 过滤器跳转页面_过滤器Filter(拦截jsp页面的跳转)案例:-程序员宅基地

- ICCV2015跟踪算法SRDCF原理及代码解析_srdcf算法问题-程序员宅基地

- k8s集群中service的域名解析、pod的域名解析_spec:servicename-程序员宅基地

- Flutter正在被悄悄放弃?浅析Flutter的未来_谷歌放弃flutter的原因-程序员宅基地

- cad标注桩号lisp_道路桩号标注(批量标注、任意点标注) - AutoCAD与GIS测绘 - CAD论坛 - 明经CAD社区 - 标注,道路中桩,文本,lisp - Powered by Dis...-程序员宅基地

- C语言编程的准则、设计模式、软件架构及思想_c语言架构设计(1)-程序员宅基地

- linux fio 导致 磁盘丢失_fio后硬盘分区消失-程序员宅基地