”随机梯度下降“ 的搜索结果

自己编写的随机梯度下降算法,附上房价预测数据集,感兴趣的可以看看

SGD随机梯度下降Matlab代码

Adam 设计用于处理随机梯度下降问题; 即当仅使用小批量数据来估计每次迭代的梯度时,或使用随机 dropout 正则化时 [2]。 有关示例,请参阅 GIT 存储库: https://github.com/DylanMuir/fmin_adam 用法: [x, fval...

随机梯度下降:大规模数据的救星 1. 背景介绍 1.1 大数据时代的挑战 在当今的数据爆炸时代,海量的数据不断涌现。无论是社交媒体平台、电子商务网站还是物联网设备,都在不断产生大量的数据。这些数据蕴含着宝贵的...

用决策树分类:从根节点开始,对实例的某一特征进行测试,根据测试结果将实例分配到其子节点,此时每个子节点对应着该特征的一个取值,如此递归的对实例进行测试并分配,直到到达叶节点,最后将实例分到叶节点的类中...

但每次迭代中只使用一个样本计算梯度,因此每次迭代的梯度都是有噪声的,毕竟不是所有样本的均值,所以下降(下山)会走一点弯路,但总体因为总的迭代次数很多,所以随机梯度下降法最终会收敛到最优解 ,还是划得来...

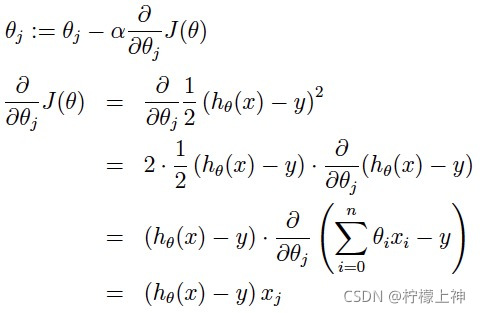

理解随机梯度下降,首先要知道梯度下降法,故先介绍梯度下降法: 梯度下降法 大多数机器学习或者深度学习算法都涉及某种形式的优化。优化本质指的是改变以最小化或最大化某个函数的任务。我们通常以最小化指代...

使用随机梯度下降算法将功能最小化。 L. Bottou的SGD和Inria的JSGD的变体。 该版本允许通过以下接口使用任意目标函数(类似于Schmidt的minFunc):sgd(funObj,funPrediction,x0,train,valid,options,varargin...

主要为大家详细介绍了Spark MLlib随机梯度下降法概述与实例,具有一定的参考价值,感兴趣的小伙伴们可以参考一下

使用SGDRegressor随机梯度下降回归从房屋交易的历史记录中发现某种规律,来预测房屋价格的走势。(极其简略的版本)划分为3个任务:任务1:可视化房屋数据任务2:训练线性回归模型任务3:测试以及评估线性回归模型1....

梯度下降是常用的优化方法之一,而批量梯度下降(BGD)和随机梯度下降(SGD)是其中的两种典型代表。本章将介绍这两种方法的比较,帮助读者更好地理解它们之间的异同点,以便在实际应用中进行选择。 在训练模型时,...

在求解机器学习算法的模型参数,即无约束优化问题时,梯度下降(Gradient Descent)是最常采用的方法之一,另一种常用的方法是最小二乘法。这里就对梯度下降法做一个完整的总结。 1. 梯度 在微积分里面,对多元...

一、为什么要提出随机梯度下降算法 注意看梯度下降法权值的更新方式(推导过程在上一篇文章中有) 也就是说每次更新权值都需要遍历整个数据集(注意那个求和符号),当数据量小的时候,我们还能够接受这种算法,...

损失使用平方函数,简单的线性模型 y = theta1 + theta2 * x

最近面试有要求手撕SGD,这里顺便就把梯度下降、随机梯度下降、批次梯度下降给写出来了。1.求梯度时注意label[i]和pred[i]不要搞反,否则会导致模型发散。2.如果跑了几千个epoch,还是没有收敛,可能是学习率太小了...

梯度下降

您需要使用课程中介绍的随机梯度下降法来实现一个版本的软边距支持向量机。您将在给定的数据集(从课程网站下载)上运行代码,然后对测试数据集进行预测。衡量你得分的标准是你在测试数据集上的准确性。(提示:由于...

资源中包含随机梯度下降逻辑回归算法的Python代码和测试数据,python的版本为3.6,您运行代码前,将测试文件路径修改为您本地的存储路径,使用pycharm平台运行即可。

这次梯度下降算法之旅,是我在探索优化世界的过程中的第一次分享,也是我对知识的虚心求教之旅。因此,我诚挚地向各位请教,希望能够从大家的经验和智慧中汲取更多的营养,使自己能够在优化的道路上更进一步。不过,...

这个术语通常指的是(或最大化)的函数。在机器学习和优化中,目标函数可以包括损失函数以及正则化项...在机器学习和深度学习中,,而梯度是一种用于指导参数更新的重要工具。(Stochastic Gradient Descent)的缩写。

该软件包演示了论文http://arxiv.org/abs/1512.04202中提出的方法,该方法展示了如何通过预处理将随机梯度下降 (SGD) 方法升级为二阶优化方法。 更多资料(伪代码、更多示例和论文)放在...

主要介绍了Python语言描述随机梯度下降法,具有一定借鉴价值,需要的朋友可以参考下

梯度下降(Gradient Descent)和随机梯度下降(Stochastic Gradient Descent,SGD)是两种常用的优化算法,广泛应用于机器学习和深度学习领域。梯度下降算法是一种迭代地寻找最小值的方法,通常用于解决具有单变量的优化...

1.背景介绍 深度学习是一种人工智能...随机梯度下降(Stochastic Gradient Descent,SGD)和Momentum是批量梯度下降的两种常见实现方法,它们在深度学习中具有重要的应用价值。 本文将从以下几个方面进行深入探讨:...

随机梯度下降算法SDG的MATLAB实现,数据集可到UCI数据库里下载

主要介绍了Keras SGD 随机梯度下降优化器参数设置方式,具有很好的参考价值,希望对大家有所帮助。一起跟随小编过来看看吧

推荐文章

- 机器学习之超参数优化 - 网格优化方法(随机网格搜索)_网格搜索参数优化-程序员宅基地

- Lumina网络进入SDN市场-程序员宅基地

- python引用传递的区别_php传值引用的区别-程序员宅基地

- 《TCP/IP详解 卷2》 笔记: 简介_tcpip详解卷二有必要看吗-程序员宅基地

- 饺子播放器Jzvd使用过程中遇到的问题汇总-程序员宅基地

- python- flask current_app详解,与 current_app._get_current_object()的区别以及异步发送邮件实例-程序员宅基地

- 堪比ps的mac修图软件 Pixelmator Pro 2.0.6中文版 支持Silicon M1_pixelmator堆栈-程序员宅基地

- 「USACO2015」 最大流 - 树上差分_usaco 差分-程序员宅基地

- Leetcode #315: 计算右侧小于当前元素的个数_找元素右边比他小的数字-程序员宅基地

- HTTP图解读书笔记(第六章 HTTP首部)响应首部字段_web响应的首部内容-程序员宅基地